核心亮点

突破数据瓶颈:摒弃传统昂贵耗时的机器人操作数据收集模式,以约 1200 万段第一人称视角的人类操作短视频为核心预训练数据,这类数据在互联网上易获取,且能涵盖烹饪、修理等丰富的人类操作场景,为模型注入通用物理世界交互知识。

操作性能优异:在真实机器人的抓取放置、长时域等操作任务中,平均成功率达到 90.6%,大幅超越 GR00T N1.5(55.6%)和 Pi0(70.4%)等主流模型,且生成的动作序列连贯平滑,让机器人操作更贴近人类自然动作。

核心技术与架构

三阶段渐进式训练框架:这是模型实现人类操作知识向机器人迁移的关键。第一阶段为第一人称视频生成预训练,训练图像到视频模型,依据初始视觉画面和语言指令预测后续视频帧,让模型掌握物体移动、工具使用等物理动态规律;第二阶段是以人为中心的轨迹感知建模,在之前基础上新增动作预测,联合预测视频帧和人类手腕关键点运动轨迹,搭建视觉与动作的关联桥梁;第三阶段是机器人中心的 VLA 建模,迁移前两阶段权重,在真实机器人数据集上微调,使其输出可解码为机器人动作的嵌入向量。

ActionVAE 动作表示技术:作为核心技术创新,这一变分自编码器可将机器人的动作块压缩为紧凑连续的潜在嵌入,推理时模型输出的嵌入向量经其解码器,能还原为可执行的连贯动作序列,既避免单步动作预测可能出现的停滞问题,又提升了动作执行的时间一致性和平滑度。

一体化 Transformer 架构:模型建立在 Chameleon 图像到视频架构之上,采用自回归 Transformer 处理语言和视觉 token 的交错序列,整合视觉编码器、语言理解模块、动作生成器三大组件,实现视觉输入处理、自然语言指令解析、机械臂控制指令输出的端到端流程。

核心功能

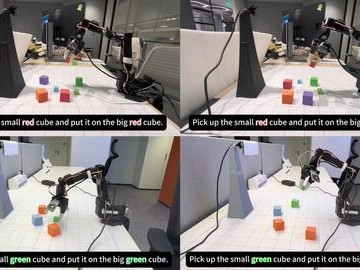

精准理解语言指令:能准确解读 “将红色物体移动到蓝色盒子中” 这类日常化的自然语言指令,明确任务目标,为后续动作执行提供准确依据。

适配复杂操作场景:不仅能完成基础的抓取、放置任务,还可应对长时域操作任务,在环境多变的真实场景中保持稳定运行状态,适配不同的机器人作业需求。

复刻类人操作模式:通过学习海量第一人称视频中的人类操作逻辑和物理动态,让机器人的机械臂动作摆脱机械感,更贴近人类操作的节奏和方式。