穹彻智能-上交大TechView|AirExo-2入选2025 CoRL Oral论文,大幅降低机器人训练成本!

近日,穹彻智能与上海交通大学联合团队共同发布的《AirExo-2:Scaling up Generalizable Robotic Imitation Learning with Low-Cost Exoskeletons》,成功入选国际机器人学习顶会2025 CoRL (Conference on Robot Learning) 的 Oral 口头报告资格,该资格在顶会中占比仅约 5%。相关论文成果将于9月27日-30日在韩国首尔举办的2025 CoRL会议现场展示。

值得关注的是,AirExo-2 系统正是穹彻核心数采产品 “CoMiner 具身数据采集套件” 的技术原型:其创新设计将缓解机器人模仿学习 “高成本、难扩展、场景适配差” 三大痛点,为零售履约、家庭服务、食品加工等场景的机器人规模化落地提供关键数据支撑。

以下内容来源于「42号电波」。

在机器人模仿学习领域,如何高效、低成本地规模化收集示教数据,并训练出能适应真实多变环境的通用机器人策略,一直是业界探索的核心。

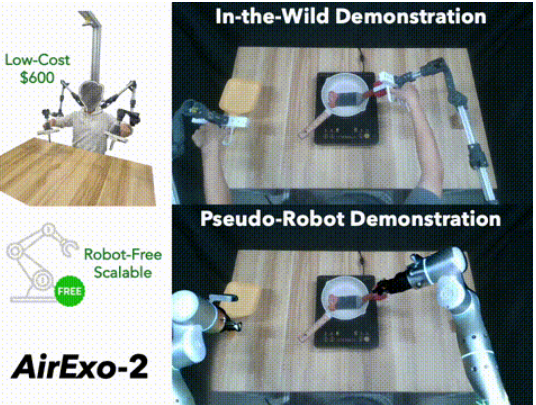

来自上海交通大学与穹彻智能的研究团队合作发表的一篇名为《AirExo-2:Scaling up Generalizable Robotic Imitation Learning with Low-Cost Exoskeletons》论文,提出了一种解决方案:AirExo-2,一个专为大规模野外数据采集设计的低成本外骨骼系统,以及与之配套的通用模仿学习策略 RISE-2。

其中,AirExo-2 能够低成本、高速率采集人体运动数据并通过一系列适配器将数据加工成伪「真机数据」,而 RISE-2 则能将这类数据的 2D 语义 与 3D 几何信息有效融合,提升机器人模仿学习效果,弥合与真机数据训练的效果差异。这套组合拳直或将找到代替真机训练的规模化方式,为机器人训练降本增效。

模仿学习的困境:为什么训练机器人那么难?

首先我们可以想象一下,你要教一个从没拿过筷子的朋友夹菜。传统方法是你手把手带他练习,但如果是训练一台机械臂呢?这就是机器人领域的经典难题——模仿学习。

目前主流方法是用遥控手柄操作真实机械臂录制动作(类似游戏手柄控制机器人),但问题显而易见:

贵:一台工业机械臂 + 力反馈手柄成本动辄几万美元,造价昂贵;

笨:遥控操作某种程度上反人类,就像用鼠标画油画,动作僵硬不自然;

难扩展:收集数据需要多台机器人同时工作,成本爆炸。

那为什么不直接记录人类的动作,再转换成机器人能理解的数据呢? 就像把人类舞蹈视频转化为机器人的动作指令。但这条路充满陷阱:

动作偏差:人类手臂与机械臂在关节数量、关节角度存在不一致,动作无法直接映射。

视觉欺骗:演示视频里出现人类手臂,但机器人执行时需要看到自己的机械臂。

视角局限:手持式装置(如 UMI、手柄)摄像头视野有限,深度感知不足。

总的来说,传统的机器人示教依赖昂贵且不灵活的遥操作平台,而直接利用野外(in-the-wild)的人类活动数据,则面临采集设备观测范围不足或因领域差异导致模型需额外机器人数据微调的难题。

穹彻智能联合上海交大团队发明的 AirExo-2 系统,相当于把人改造为半个「机器」去直接采集「真机数据」。

AirExo-2 是一款升级版的低成本外骨骼,通过一系列精巧的「适配器」,能够将野外采集到的人体动作数据高效转化为机器人可用的「伪机器人示教(pseudo-robot demonstrations)」,为后续的策略学习铺平道路。

一方面,在硬件设计上,这款外骨骼采用轻量化铝合金框架替代易变形的 3D 打印件,关节能精准模仿真实机器人的活动范围(比如机器人手臂能转 180°,外骨骼也只能转 180°),成本仅 600 美元(约等于一台入门级手机),而遥操作平台可能需要 6 万美元。同时其自带 「全局摄像头」:头顶的深度相机能够实时拍摄人类操作场景,记录动作轨迹和环境视觉。

另一方面,这一数采系统通过一系列适配器,可将人体数据转为某种伪「真机数据」:

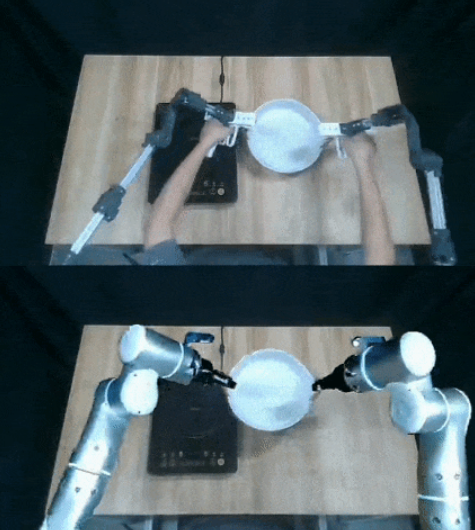

视觉适配器:通过图像修复(Inpainting)去除人类手部和外骨骼,叠加渲染的机器人模型,生成 「伪机器人视角」的 RGB-D 图像,弥合人类操作与机器人视角的差异。比如人类用外骨骼抓杯子的画面,会被处理成机器人抓杯子的虚拟画面。

深度适配器:利用参考深度图修复人体遮挡区域,确保空间一致性。

动作空间适配器:将外骨骼关节角度映射到机器人坐标系,实现动作的直接迁移。

有了高质量的示教数据,一个强大的学习策略同样不可或缺。为此,团队提出了 RISE-2,一种可泛化的 3D 模仿学习策略。

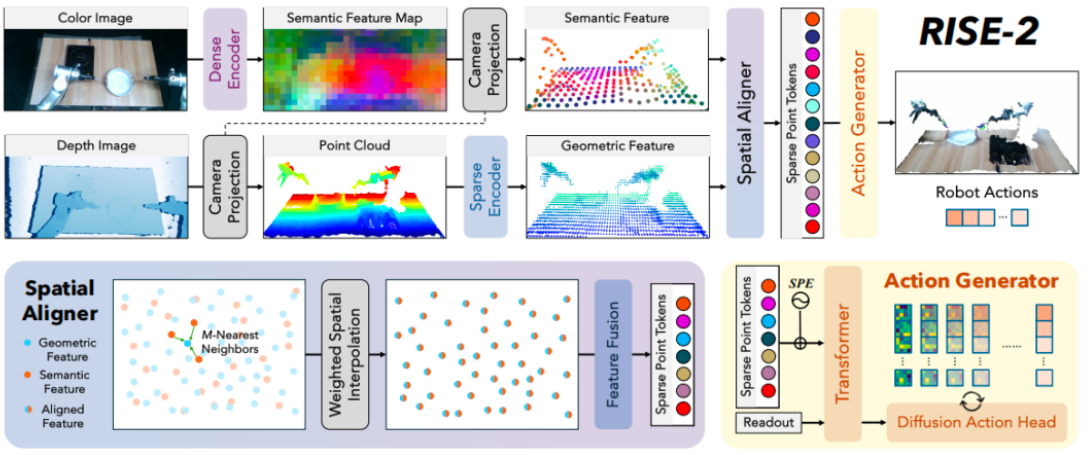

RISE-2 的核心设计理念在于精准融合 2D 图像的语义信息和 3D 点云的空间信息。它包含四大模块:

稀疏编码器(3D 几何):基于 MinkowskiEngine 处理点云,提取局部几何特征(如物体形状、位置),聚焦空间结构理解。它提取的是物体的空间信息。用「杯子」举例来理解的话,这一模块主要是为提取杯子的形状、位置等信息。

密集编码器(2D 语义):采用预训练视觉模型 DINOv2 提取图像语义特征(如物体类别、场景上下文),增强对复杂场景的理解。它能够帮助理解物体是什么,比如这是一个杯子而不是一个碗。

空间对齐器:通过 3D 坐标加权插值融合两类特征,确保几何与语义信息精准对齐,提升动作预测的准确性。这一模块主要是为了让 3D 与 2D 信息深度融合,让机器人同时理解 「这是什么」和 「该怎么抓」。

动作生成器:包含带稀疏位置编码的 Transformer 和基于扩散模型(Diffusion Policy)的动作生成头。先将稀疏位置编码为点 token,然后将其映射到动作特征空间。而后这些动作特征通过扩散解码为连续的动作轨迹,进而完成机器人长时序任务规划。

数采成本评估

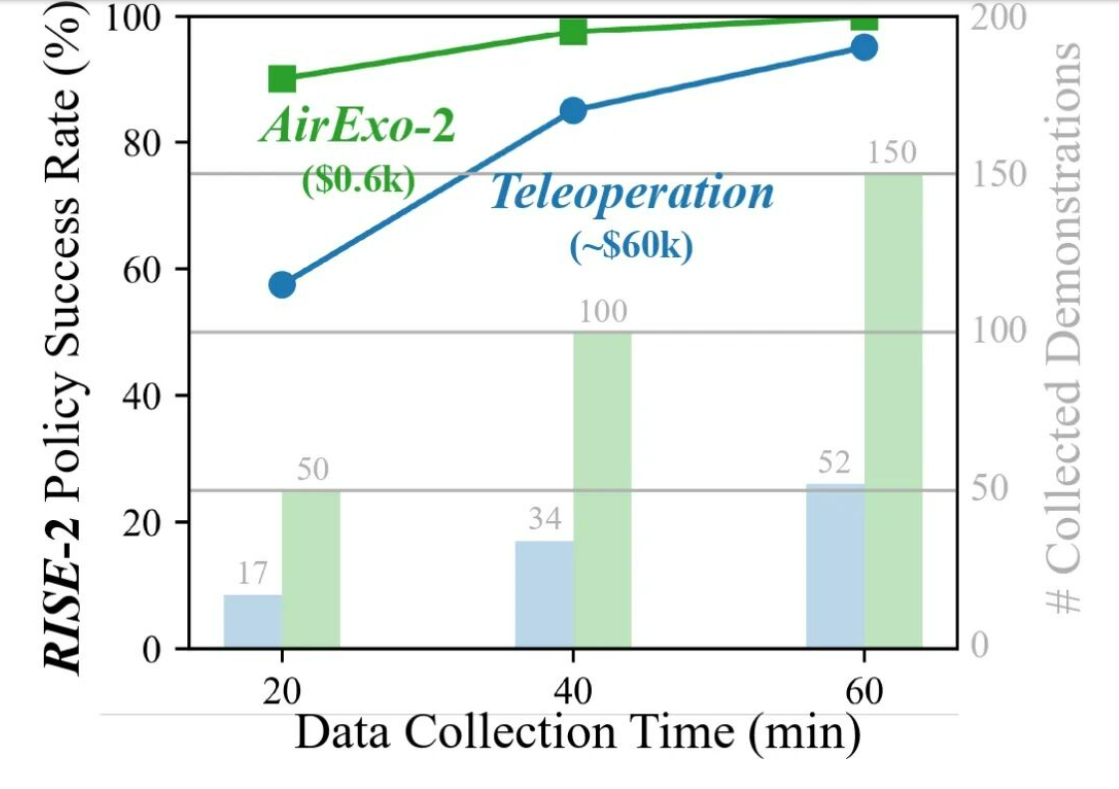

研究放出了这套方案的成本,AirExo-2 采集 50 个示教的时间仅为远程操作的 1/3,且用户更容易学习使用机器,上手采集。

与此同时,在采集成本方面,单套 AirExo-2 成本仅为远程操作平台(约 6 万美元)的 1%,适合大规模数据采集。

策略性能评估

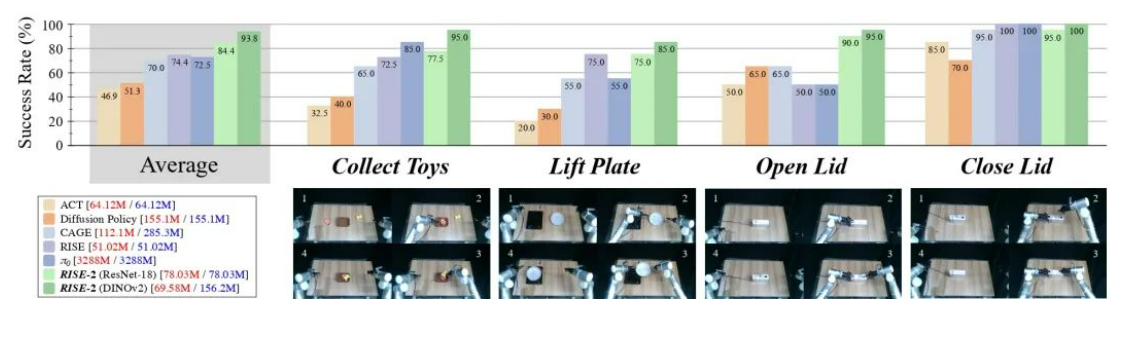

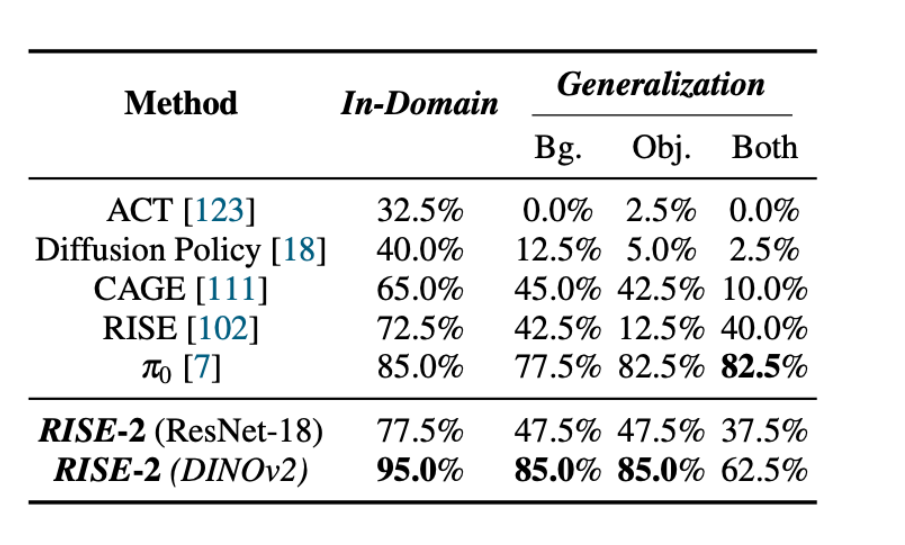

为评估不同策略在领域内任务(In-Domain)和泛化任务(Generalization)中的表现,作者设计了四个操控任务——收集玩具、抬起板子、打开盖子及关闭盖子,并分别通过遥操作方式收集每个任务的 50 条演示,进行策略性能评估。

首先是领域内任务方面,即在与训练环境(遥操作示教)相同的条件下评估策略性能。实验发现,在 4 类任务中,RISE-2 平均成功率达 93.75%,显著优于一众基线方法。

其次是泛化能力方面,即在未经训练的全新环境中评估策略的适应能力。研究发现,在收集玩具任务中,面对新背景、新物体时,RISE-2 成功率仍达 62.5%,虽不及 π0 的 82.5% 成功率,但需要注意的是,π0 参数量(3B)远高于 RISE-2 (约160M),且 π0 的预训练数据中包含大量抓放类任务。

最后是零样本迁移方面,仅用 AirExo-2 数据训练的 RISE-2,在真实机器人上的表现与用远程操作数据训练的策略接近(差距仅 8.75%),验证了 「伪机器人数据」 的有效性。

此外,研究还做了「关键组件消融实验」,即将 AirExo-2 与 RISE-2 的核心组件去掉一部分后进行性能对比。研究发现,在数采环节中,视觉适配器很重要。当研究人员移除 AirExo-2 中的视觉适配器后,RISE-2 成功率从 90% 骤降至 52.5%,这证明图像适配是弥合领域差距的核心。同时,在策略性能上,研究团队把 RISE-2 中的 DINOv2 替换成了 ResNet18,发现效果明显下降,从而验证了 visual foundation model 对模型性能的提升。

总的来说,AirExo-2 系统与 RISE-2 策略的结合,为机器人模仿学习领域提供了一条低成本、高效率、可扩展的全新路径。它不仅降低了高质量示教数据的获取门槛,也为训练更通用的机器人智能体开辟了新的可能性。这些成果为在野外环境中学习到的操作技能迁移到真实机器人开辟了新途径,且无需大量以机器人为中心的数据收集。

如需了解更多技术细节,点击“阅读原文”可跳转至 AirExo-2 项目地址。

关于 穹彻智能

穹彻智能是一家专注于开发和应用具身智能技术的前沿科技公司,聚焦“以力为中心”的具身智能大模型和相关基础设施的研发,为不同行业的客户提供创新的通用机器人智能解决方案和服务,以解决现实世界中的复杂问题。